Google luôn thay đổi các thuật toán của mình để đưa ra các kết quả tìm kiếm ngày càng thông minh hơn và “khắt khe” hơn đối với những nhà SEOer website. Dưới đây là 8 thuật toán quan trong của Google mà chúng ta có lẽ phải biết để làm đúng và không vi phạm các quy tắc của Google. Đưa site của mình lên TOP 1 của Google sẽ không còn khó khăn nhưng bạn nên nhớ rằng “Sân chơi nào cũng phải có luật chơi của nó”.

Thuật toán của Google là gì?

Các bạn biết đấy, Google thường xuyên phát hành các thuật toán mới, chỉ tính riêng năm 2012 Google đã có 665 bản update. Đương nhiên, nhiệm vụ của mỗi lần update là cải thiện kết quả cho mỗi lần truy vấn để đáp ứng được múc địch tìm kiếm của người dùng. Vậy là Google nâng cấp các thuật toán để tìm kiếm chính xác hơn.

Song song đó các thuật toán cũng kiêm luôn việc trừng phát các website kém chất lượng, spam không tuân theo các nguyên tắc chung hay nói cách khác là dùng tiểu xảo để lên TOP tìm kiếm. Hành động mạnh tay này của Google thật thật đáng hoan nghênh.

1. Có “Đầu vào” thì mới có “Đầu ra”

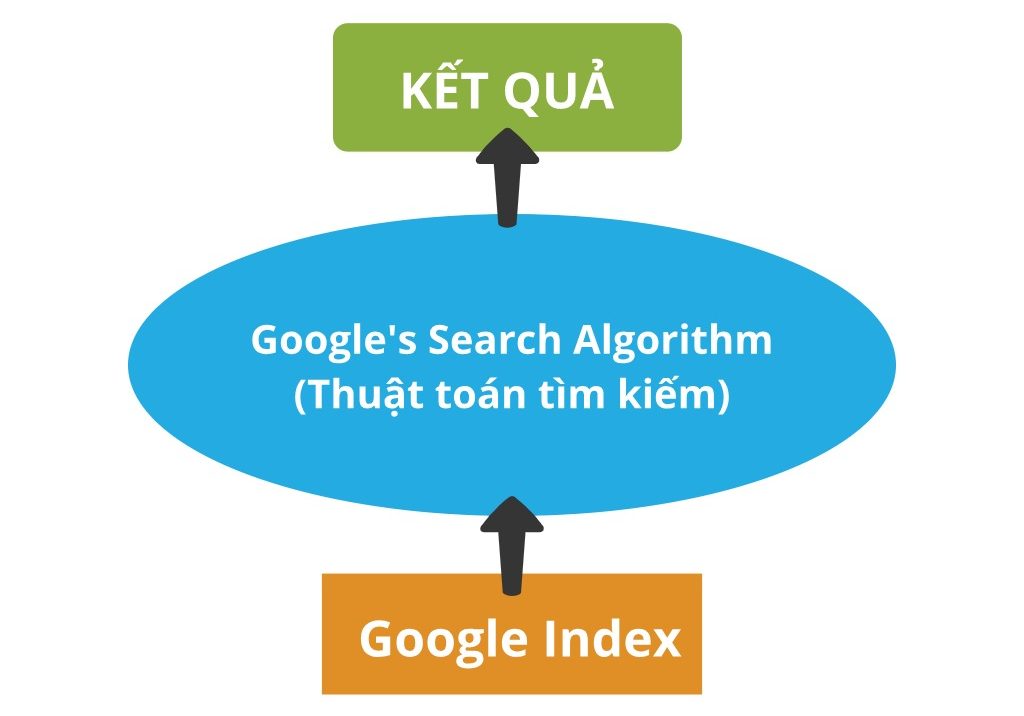

Để có thể đưa ra các màn hình kết quả từ bộ máy tìm kiếm SERPs thì việc điều đầu tiên của Google sẽ phải index được dữ liệu từ phía trăm ngàn triệu website. Công việc tưởng chừng như chỉ cần có “Đầu vào” là sẽ có “Đầu ra” này tưởng như đơn giản nhưng thực ra lại phức tạp hơn chúng ta nghĩ. Thế mới là Google Index.

Việc index được tiến hành từ hàng chục các trung tâm dữ liệu trên toàn thế giới của Google, và từng trung tâm dữ liệu này được coi như một thành phố dữ liệu thu nhỏ, liên kêt bởi một trong những hệ thống toàn cầu tân tiến nhất.

Quá trình index được minh họa như sau:

Trên thế giới có hàng triệu website liên quan về những lĩnh vực và ngành nghề khác nhau. Vậy để xử lí và tính toán hết tất cả các thông tin thì Google cần phải có thuật toán thông minh.

Những thuật toán được điều chỉnh sao cho kết quả cho mỗi từ khóa tìm kiếm là khác nhau. Dù chỉ là thay đổi nhỏ như lỗi đánh máy, trật tự sắp xếp các từ… thì các thuật toán này cũng đưa đến người dùng đến những kết quả khác nhau.

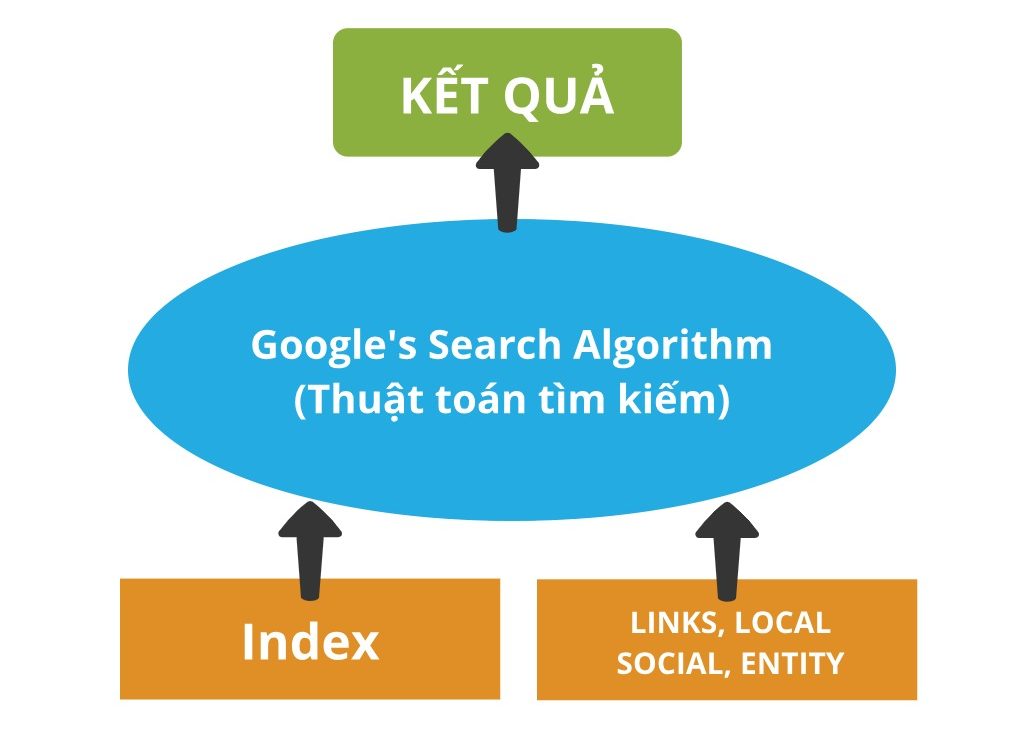

Tuy nhiên, Index không phải là Đầu vào quan trọng nhất của thuật toán, chúng ta phải hiểu là nó còn có rất nhiều đầu vào liên quan khác. Như mô tả bằng hình bên dưới:

Ngoài Index ra chúng ta còn có các hệ thống liên kết (links), dữ liệu địa phương, mạng xã hội hay các yếu tố khác mà Google thu thập được từ website trên thế giới.

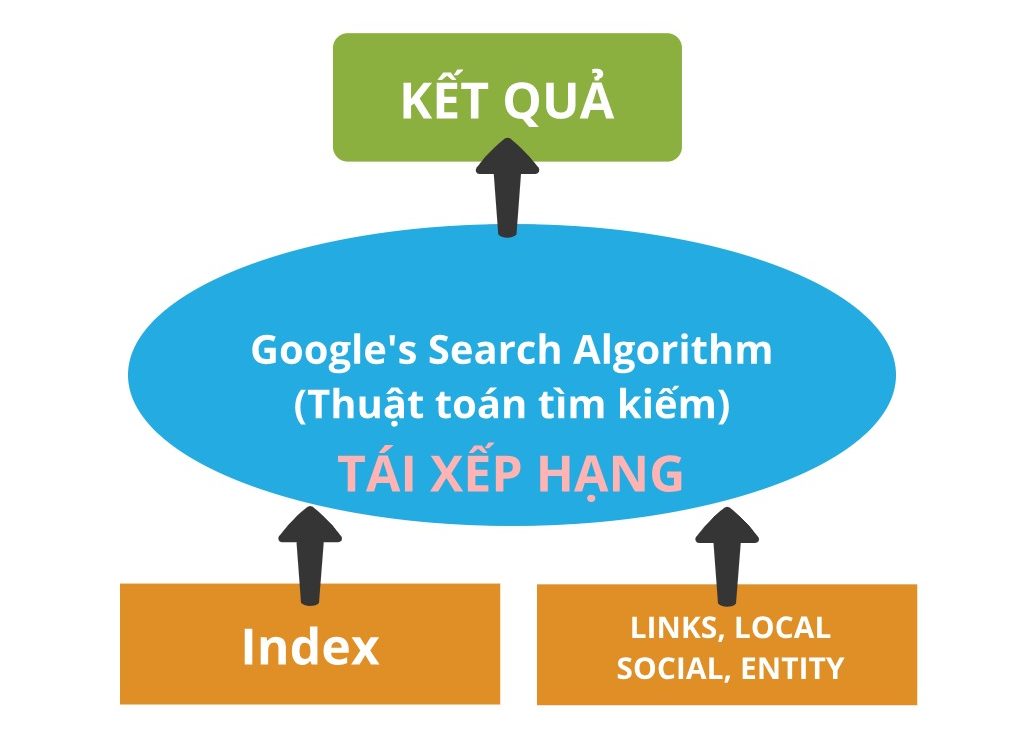

2. Xếp hạng và tái xếp hạng

Chúng ta sẽ luôn quan tâm đến xếp hạng website của mình trên kết quả tìm kiếm của Google. Đương nhiên xếp hạng này không phải lúc nào cũng là cố định, nó có cơ chế tái xếp hạng. Cho nên cuộc rượt đuổi về thứ hạng cao trong tìm kiếm không bao giờ dừng lại. Website nào làm tốt hơn, “chuẩn” Google hơn sẽ có thứ hạng cao trong kết quả tìm kiếm trả về.

Đầu tiên, Google sẽ dựa vào thuật toán tìm kiếm để “nhặt ra” những trang chứa nội dung phù hợp. Sau đó sắp xếp các trang này theo thứ tự dựa vào sự tương thích của trang như: có thể có nhiều links, có google+, có chỉ số giá trị (citation) trên thế giới. Và nếu như thấy trang không phù hợp với câu truy vấn, nó sẽ không được xuất hiện trong kết quả tìm kiếm đó. Đây là kết quả xếp hạng tự nhiên đối với những trang tương thích.

Bước tiếp theo, là bước rất quan trọng Google sẽ tái cơ cấu lại kết quả xếp hạng dựa vào các thuật toán cao cấp. Nó bao gồm rất nhiều yếu tố như: tin tức, hình ảnh, video, các links, địa phương… bla bla có trong trang để Google đánh giá và tái xếp hạng thứ hạng trong kết quả tìm kiếm. Nói tóm lại là ở bước này nó sẽ không còn tự nhiên nữa, Google sẽ bắt đầu chạy các thuật toán cao cấp hơn để tìm ra, tính toán đưa ra các kết quả tìm kiếm chính xác nhất và thứ hạng sắp xếp trong kết quả tìm kiếm sẽ bắt đầu thay đổi lớn từ đây.

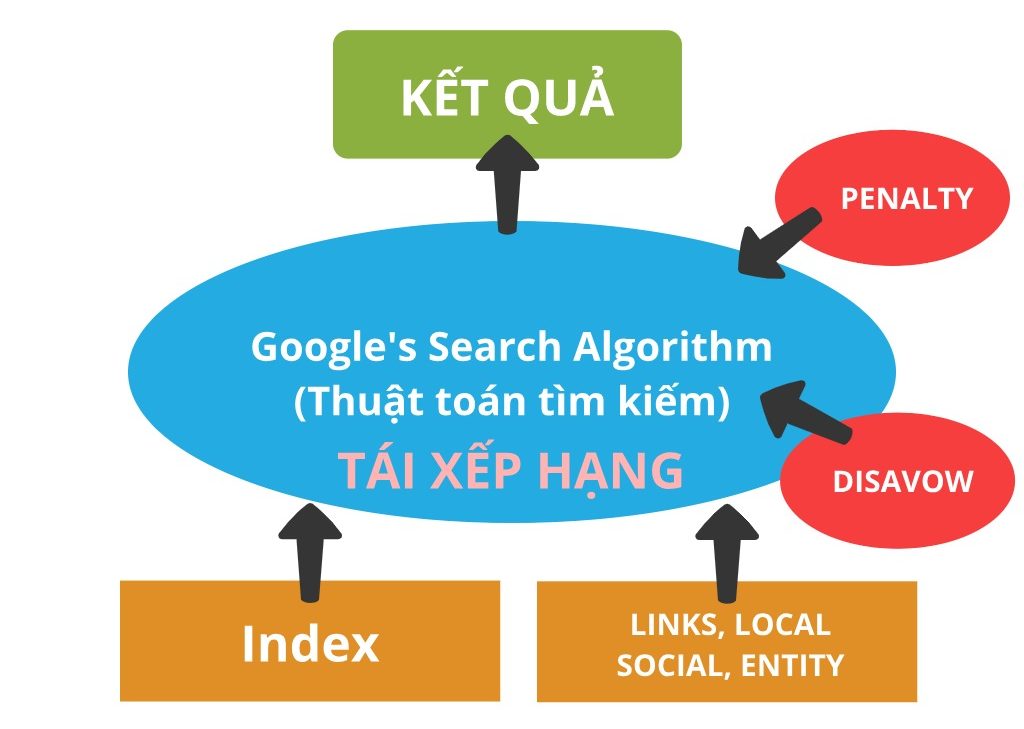

3. Có những “Đầu vào” đặc biệt, các hình phạt và disavow

Manual penalty là một đầu vào đặc biệt (special inputs). Google áp dụng hình phạt thủ công cho site, việc này được đánh dấu ở đâu đó và đưa vào hệ thống, và cũng là một phần của index. Nhưng vì quá trình này được thực hiện thủ công, liên quan đến Google Webmaster Tools, nên chúng ta nên xem nó là một khái niệm riêng biệt.

Tương tự, công cụ Disavow cũng là một đầu vào riêng biệt, được quản lý bởi các nhà quản trị mạng, dữ liệu này được xử lý định kỳ và được đưa trở lại các thuật toán. Còn có nhiều đầu vào tác động đến các thành phần khác của hệ thống, ví dụ XML sitemaps trong Google Webmaster Tools giúp việc định hình quá trình index.

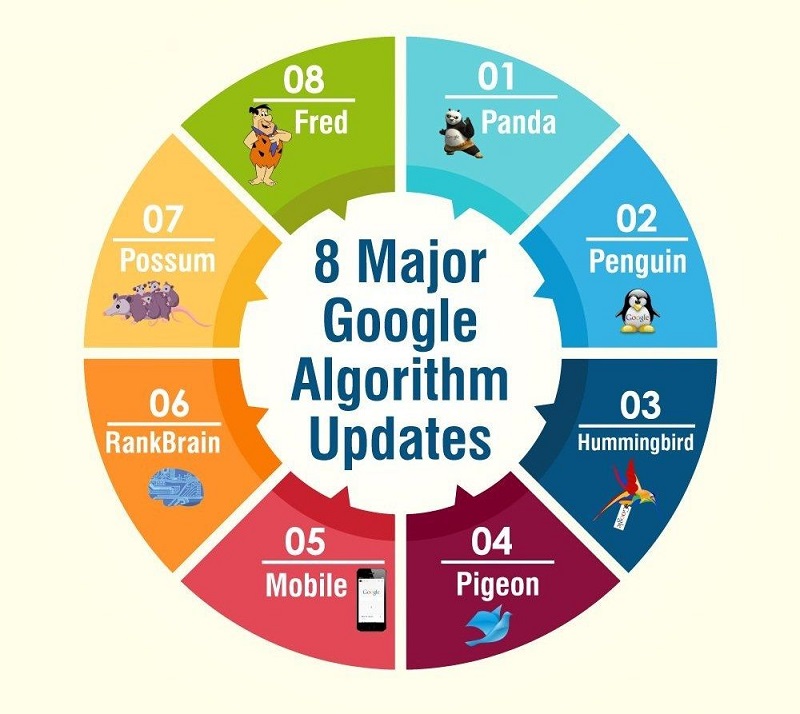

Các thuật toán cốt lõi của Google cập nhật 2020

Google thường xuyên phát hành các thuật toán mới, nhiệm vụ của nó là cải thiện kết quả cho mỗi truy vấn đáp ứng được ý định tìm kiếm của người dùng, và trừng phạt các website kém chất lượng, spam không tuân theo các nguyên tắc, chất lượng. Dưới đây là 8 thuật toán cốt lõi của Google được cập nhật mới nhất năm 2020.

1. Thuật toán Google Panda

Ra mắt: ngày 24 tháng 2 năm 2011

Cập nhật: Hàng tháng

Mục đích: Giảm xếp hạng của các trang web nội dung chất lượng thấp

Cập nhật Google Panda trong SEO

Cập nhật Google Panda áp đặt hình phạt đối với các trang web có nội dung chất lượng thấp, spam hoặc mỏng. Hơn nữa, các trang web với Keyword Stuffing (nhồi nhét từ khóa), Trải nghiệm người dùng kém và đạo văn phải trả giá.

Thuật toán mã hóa Panda Panda thường trừng phạt để làm gì?

- Nội dung không nguyên bản (đạo văn);

- Nội dung trùng lặp trên các trang khác nhau của cùng một trang web;

- Nội dung tự động;

- Nội dung tràn ngập từ khóa;

- Nội dung spam được tạo bởi người dùng (ví dụ: bình luận);

- Thin Content – Số lượng nội dung không đủ trên một trang;

- Trải nghiệm người dùng không tốt.

Những điều cần tránh:

- Nội dung trùng lặp (sử dụng Copyscape)

- Đạo văn

- Nhồi nhét từ khóa

Cách để tránh hình phạt từ Panda

- Kiểm tra các trang web có tính duy nhất, kiểm tra định kỳ nội dung của bạn

- Kiểm tra sự trùng lặp nội dung, Title hay thẻ H1

Một số yếu tố nội dung dưới đây có thể bị thuật Panda đánh dấu:

- Nội dung sơ sài: Các trang web với nội dung không phù hợp, thiếu xác đáng, ít thông tin, ít nguồn.

- Nội dung sao chép: Các nội dung bị sao chép trên Internet nhiều hơn một lần, hoặc bị lặp lại trên website của bạn quá nhiều lần (ví dụ như trang web bán hàng chứa các trang có mô tả các sản phẩm giống nhau, chỉ khác biệt về giá cả).

- Nội dung chất lượng kém: Các website có nội dung không giá trị cho người dùng bởi thiếu hụt thông tin sâu.

- Trang web thiếu uy tín, thẩm quyền: Một số trang web bị đánh dấu do nguồn thông tin không rõ ràng.

- Content farming: Trang web chứa nhiều nội dung tổng hợp, sao chép từ nhiều website khác chỉ với mục đích tăng thứ hạng trang.

- Nội dung tự tạo chất lượng thấp: Các nội dung mắc lỗi chính tả, quá ngắn.

- Tỷ lệ nội dung quảng cáo lớn: Các trang web được tạo nên nhằm chạy quảng cáo với tỷ lệ nội dung quảng cáo lớn hơn nội dung thường.

- Website bị chặn bởi người dùng: Một số trang bị chặn trực tiếp bởi người dùng trên công cụ tìm kiếm bằng công cụ Chrome browser extension cho thấy trang có nội dung kém, spam.

- Nội dung không khớp với từ khóa tìm kiếm: Nội dung không phù hợp, không đáp ứng được nhu cầu tìm kiếm của người dùng.

2. Thuật toán Google Penguin

Hay còn gọi là cập nhật chim cánh cụt của Google. Tương tự như Panda, Penguin hướng tới loại trử các website kém chất lượng, ưu tiên website tốt bằng việc rà soát các đường link dẫn và keyword sử dụng.

Ra mắt: ngày 24 tháng 4 năm 2012

Cập nhật: hiện đang cập nhật trong thời gian thực

Mục đích: Hạ xếp hạng các trang web chứa hồ sơ có liên kết spam và các trang web thao túng trọng lượng liên kết

Cập nhật Google Penguin máy cắt chừng phạt những site:

- Link schemes: tham gia mạng liên kết nhằm thao túng xếp hạng

- Mua bán liên kết

- Trao đổi liên kết quá mức

- Sử dụng chương trình tự động tạo liên kết

- Vv tham khảo những link mà Google coi là không tự nhiên tại: Google quality guidelines

- Nhồi nhét từ khóa

- Tối ưu quá đà

- Liên kết không tự nhiên

Google Penguin xử lý chất lượng liên kết và xử phạt những trang web mua backlink từ các trang của bên thứ ba. Ngoài ra, các trang web không theo hướng dẫn của Google Webmaster phải đối mặt với các hình phạt.

Làm thế nào để tránh hình phạt từ Penguin?

- Theo dõi những thay đổi trong hồ sơ backlinks, định kỳ ít nhất 1 lần/tuần

- Loại bỏ và từ chối các liên kết độc hại

Để có hồ sơ backlink tốt, việc từ chối nhận backlink xấu không mong muốn có thể do đối thủ tặng cả một tấn backlink có hại, Google cung cấp công cụ từ chối liên kết (Disavow links) tại: https://www.google.com/webmasters/tools/disavow-links-main

Với sự trợ giúp của công cụ này, chúng tôi có thể xóa bất kỳ liên kết nào gây hại cho trang web của chúng tôi và thông báo cho google không xem xét liên kết từ liên kết cụ thể đó.

2 nhân tố Penguin nhắm đến bao gồm:

- Link dẫn: Thao túng, mua bán backlink từ những website kém uy tín, tạo nên sự phổ biến “ảo” nhằm nâng cao giá trị website, qua mắt Google đẩy thứ hạng web sẽ bị Penguin “sờ gáy”. Các đường link dẫn thiếu tự nhiên, có nội dung không khớp với mô tả đường dẫn từ bên thứ ba có thể bị Penguin đánh dấu spam.

- Lạm dụng từ khoá: Sử dụng số lượng lớn từ khóa hay lặp đi lặp lại từ khoá nhằm thao túng xếp hạng tìm kiếm sẽ có thể bị Penguin để ý.

3. Thuật toán Google HummingBird (Chim ruồi)

Ra mắt: ngày 30 tháng 8 năm 2013

Cập nhật: chưa rõ

Mục đích: Để cung cấp kết quả phù hợp hơn, dựa trên thành phần ngữ nghĩa của yêu cầu tìm kiếm Trí tuệ nhân tạo trong Google Hummingbird. Học máy trong Google Hummingbird.

Google HummingBird được ra mắt để xử lý Từ khóa đuôi dài dựa trên ý định của người dùng. Nó lấy ra những kết quả tìm kiếm phù hợp với mục đích của người tìm kiếm, thay vì phù hợp các từ khóa trong truy vấn.

4. Thuật toán Google Pigeon

Ra mắt: ngày 24 tháng 7 năm 2014

Cập nhật: ngày 22 tháng 12 năm 2014

Mục đích: Để cung cấp kết quả tìm kiếm địa phương phù hợp hơn

Cập nhật chim bồ câu của Google tập trung vào khoảng cách và khoảng cách gần của người dùng.

Google Pigeon Update cung cấp kết quả chính xác, phù hợp hơn dựa trên vị trí của người dùng và các yếu tố địa lý khác. Do SEO địa phương này trở nên nổi bật và Google Doanh nghiệp trở thành một thành phần thiết yếu cho thấy các thực thể trên bản đồ dựa trên ba yếu tố.

- Sự liên quan

- Khoảng cách tìm kiếm

- Nổi tiếng(Prominence)

Vì vậy, NAP (Tên, địa chỉ và số điện thoại) Tính nhất quán là yếu tố chính để có lợi thế hơn đối thủ của bạn.

Một số cập nhật của Pigeon có thể kể đến như:

- Kết nối sâu hơn thuật toán tìm kiếm địa phương với thuật toán website truyền thông nhằm nâng cao khả năng tìm kiếm và hiển thị. Điều này thúc đẩy doanh nghiệp địa phương tối ưu trang web, xây dựng giao diện hiển thị rõ ràng nhằm cạnh tranh xếp hạng.

- Phạm vi, bán kính tìm kiếm được thu hẹp ưu tiên những địa điểm kinh doanh gần nhất. Bản đồ định vị thu hẹp khiến không ít doanh nghiệp bị đẩy ra ngoài vùng gợi ý.

- Từ hiển thị 7 kết quả tìm kiếm, hiện tại Google chỉ cho hiển thị 3 kết quả địa điểm.

5. Thuật toán Mobile Friendly

Ra mắt: ngày 21 tháng 4 năm 2015

Cập nhật: chưa rõ

Mục đích: Để tăng hạng các trang được tối ưu hóa cho thiết bị di động trong kết quả tìm kiếm được gửi đến thiết bị di động.

Cập nhật thân thiện với thiết bị di động của Google hay còn gọi là Mobilegeddon đảm bảo rằng các trang web được tối ưu hóa cho thiết bị di động được coi trọng trong SERPs (Trang kết quả của công cụ tìm kiếm). Vì vậy, tính thân thiện với thiết bị di động đã trở thành một đặc điểm thiết yếu và Dự án tăng tốc độ mobile (AMP) được Google cung cấp để tăng cường tốc độ tải trang trên đi động.

Thuật toán này được Google đưa ra nhằm đáp ứng nhu cầu của lượng lớn người dùng di động tra cứu từ khoá. Bên cạnh chất lượng nội dung, tốc độ tải trang trên thiết bị di động cũng đóng vai trò lớn trong xếp hạng. Điều này thúc đẩy những nhà xây dựng web tối ưu website, tích hợp đa thiết bị, chạy tốt trên các nền tảng di dộng.

6. Thuật toán Google RankBrain

Ra mắt: ngày 26 tháng 10 năm 2015

Mục đích: Cung cấp cho người dùng kết quả tốt nhất dựa trên cả mức độ phù hợp và học máy Trí tuệ nhân tạo Google Rankbrain.

RankBrain là thuật toán Trí tuệ nhân tạo Machine Learning giúp cải thiện kết quả tìm kiếm từ khóa dựa trên ý định của người dùng. Machine Learning là một quá trình mà máy tính dạy cách tự thực hiện một nhiệm vụ cụ thể, thay vì được dạy bởi con người. Thông qua AL, công cụ tìm kiếm hoạt động thông minh như con người bằng cách hiểu các vấn đề trong thế giới thực và giải quyết nó.

Sử dụng nguyên tắc trên, RankBrain diễn giải người dùng từ khóa tìm kiếm không khớp với từ chính xác mà họ đang tìm kiếm.

Thuật toán RankBrain là một thuật toán học máy phức tạp, chúng ngày càng cải tiến, đưa ra những kết quả phù hợp hơn bằng một quá trình lâu dài học hỏi dữ liệu từ người dùng và từ khoá.

Để nâng cao thứ hạng trang, bạn cần nắm rõ và lưu ý những vấn đề sau:

- Từng từ khóa khác nhau sẽ có những yêu cầu khác nhau trong việc ưu tiên xếp hạng, với những từ khóa liên quan đến tra cứu kiến thức, nội dung cần phải sâu, có nguồn chính thống, với những từ khóa như cập nhật thiên tai thì cần mới, xác thực.

- Uy tín của website cũng là một trong những nhân tố ảnh hưởng đến xếp hạng, hãy xây dựng uy tín một cách tự nhiên, chú trọng vào đào sâu chủ đề chính bao phủ toàn bộ web nhằm phục vụ người dùng tìm kiếm từ khóa đó.

- Sử dụng đa dạng từ khóa cho nội dung thay vì SEO truyền thống sử dụng lặp lại một từ khóa nhất định với nhiều biến thể tương đồng.

7. Thuật toán Google Possum

Ra mắt: ngày 1 tháng 9 năm 2016

Cập nhật: chưa rõ

Mục đích: Để cung cấp kết quả tìm kiếm địa phương tốt hơn, phù hợp hơn dựa trên vị trí của người dùng.

Google Possum đã giới thiệu nhiều thay đổi khác nhau liên quan đến SEO địa phương.

- Vị trí thực tế của Người tìm kiếm: Doanh nghiệp gần khoảng cách của người tìm kiếm có nhiều khả năng xuất hiện trong SERPs.

- Các doanh nghiệp được đặt tại vùng ngoại ô của một thành phố cụ thể, bây giờ xuất hiện trong kết quả thành phố mục tiêu và những doanh nghiệp có nhiều Danh sách Google My Business có cùng NAP đã được xếp hạng.

8. Thuật toán Google Fred

Ra mắt: ngày 8 tháng 3 năm 2017

Cập nhật: chưa rõ

Mục đích: Lọc các trang chất lượng thấp khỏi kết quả tìm kiếm có mục tiêu chính để kiếm lợi từ quảng cáo và liên kết đến các trang web khác

Thuật toán Google Fred được thiết kế nhắm đến chiến thuật SEO blackhat. Thuật toán rà soát các website chứa lượng lớn quảng cáo, nội dung kém chất lượng không đem lại giá trị cho người dùng. Các trang web với mục đích chính là kiếm tiền thay vì đưa đến nhiều thông tin hữu ích cho người dùng có thể bị liệt vào “sổ đen”.

Một số nhân tố có thể ảnh hưởng xấu đến website:

- Hiển thị quảng cáo sai lệch hoặc lừa đảo

- Hiển thị quảng cáo có khả năng đánh lừa người dùng click chuột

- Bao phủ bởi những link dẫn, quảng cáo, nội dung kém chất lượng

- Gặp vấn đề về trải nghiệm người dùng

- Tích hợp di động kém

- Nội dung trang sơ sài

- Lạm dụng quảng cáo

Kết

Như vậy là chúng ta đã nghiên cứu xong các thuật toán phức tạp của Google trong quá trình làm việc để xếp hạng các kết quả tìm kiếm. 8 thuật toán trên không phải là tất cả, nhưng nó đại diện cho 1 bộ máy khủng khiếp mang tên Google và nó hàng ngày, hàng tháng được cập nhật thông minh hơn để tạo ra một sân chơi bình đẳng – công bằng.

Nói các khác là thuật toán của Google sẽ thưởng phạt nghiêm minh hơn rất nhiều. Vì vậy hãy tử tế hơn với nội dung website của bạn và điều quan trọng nhất của người làm SEO là biết đầu vào của mình như thế nào để Google Index một cách thoải mái nhất.

Chúc các bạn thành công!

![[Full PDF] Download truyện Harry Potter bản tiếng Anh Top 7 bộ phim phù thủy hay nhất mọi thời đại](https://type.vn/wp-content/uploads/2021/11/harry-potter-movies-on-netflix-100x75.jpg)